<본 글은 『월간 방송과기술』 2024년 01월호에 실린 원고입니다.>

[월간 방송과기술 이진범 기자] 한 해의 방송기술 주요 이슈를 살펴보며, 방송/영상 기술 분야의 발전 방향에 대해 정리해 볼 수 있는 디브이네스트의 DWF(DVNEST Webinar Festival) 2023이 지난 12월 6일 오후 2시부터 약 2시간 동안 유튜브를 통해 라이브 스트리밍되었다.

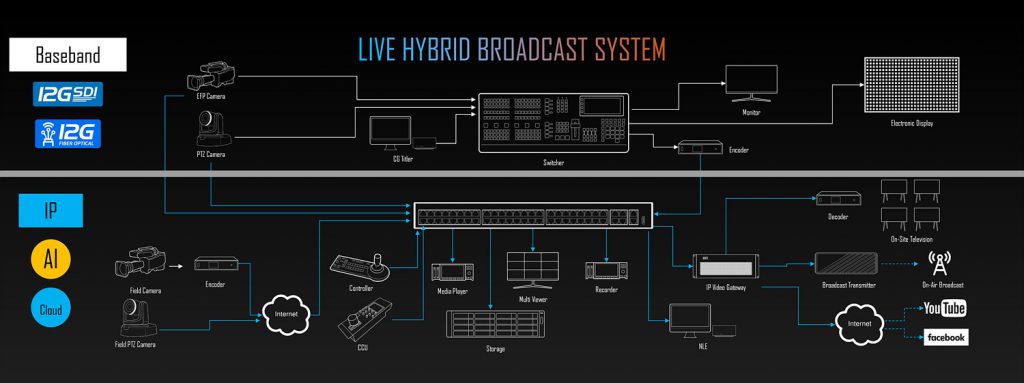

DWF 2023은 크게 세 개의 세션으로 방송기술 트렌드의 과거와 현재, 미래를 살펴보는 시간으로 이광희 디브이네스트 대표를 비롯한 디브이네스트 직원들이 많은 시간을 들여 준비와 발표를 직접 하고 있다. 이광희 대표가 설명한 첫 번째 웰컴 세션에서는 ‘2023 방송기술 총정리’를 주제로 올해 가장 관심을 받았던 방송기술 주요 이슈와 트렌드에 대해 소개되었다. 먼저, 기존 ‘Baseband Broadcast System’을 대체할 ‘Live Hybrid Broadcast System’에 대한 소개가 이어지며 메인 트렌드인 ‘Camera’, 12G-Fiber Optical’, ‘Multi Viewer’, ‘Cloud’, ‘AI’의 5가지 주제에 대해 심도 있게 소개되었다.

두 번째 세션인 ‘발품 컨설팅 – 워크플로우의 모든 것’에서는 디브이네스트에 의뢰된 사연을 바탕으로 ‘대형교회’, ‘소규모 현장 중계’, ‘해외 원격 중계’ 등 다양한 현장에서 사용되는 최신 워크플로우에 대해 소개되었다. 세 번째 세션에서는 ‘VMA 2023(비디오마트 어워드)’을 통해 방송장비 전문 쇼핑몰인 비디오마트에서 판매된 제품들을 대상으로 올해의 장비를 선정하는 시간을 가졌다. ‘방송과기술’에서는 첫 번째 세션에 대한 리뷰를 통해 올 한해의 주요 방송기술 트렌드에 대해 살펴보고자 한다.

2023 방송기술 총정리

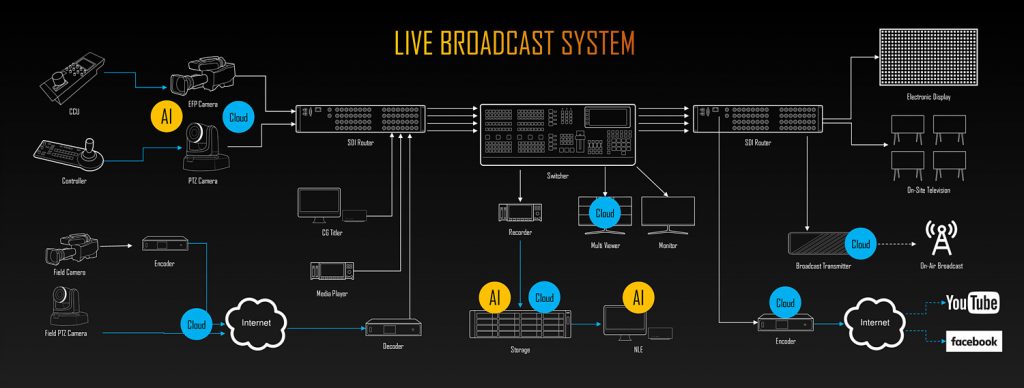

이광희 대표는 주요 방송기술 이슈를 설명하기 전 기존 베이스밴드 기반의 ‘Live Broadcast System’에 대해 소개하며, 4K 제작의 필요성으로 방송제작에 많은 장비와 시스템이 필요하지만, 점차 IP, AI와 Cloud 기술의 발전으로 ‘Live Hybrid Broadcast System’으로 바뀌는 추세라고 소개했다. 기존 SDI를 기반으로 하는 베이스밴드 시스템은 화질과 간편한 구성, 적은 딜레이 등을 봤을 때 안 쓸 이유가 없으며, 새롭게 적용되고 있는 IP 기반의 시스템에 AI, Cloud 기술이 적용되면 역시 경제성과 편리성이 뛰어나기 때문에 갑작스럽게 모든 부분이 바뀌지는 않겠지만 당분간은 이 두 시스템이 혼용되어 사용될 것으로 내다봤다.

주요 이슈 1. CAMERA

안정성의 이유로 가장 보수적으로 발전하는 경향이 있는 카메라 분야 역시 점차적인 발전이 이루어지고 있다. 무엇보다 PTZ 카메라의 활용도가 더욱 늘어날 것으로 보인다.

1. Blackmagic Camera App

새롭게 등장한 Blackmagic Camera App은 기존의 스마트폰을 방송용 카메라로 만들어 주며, 다양한 기능과 간편한 설정으로 많은 관심을 받고 있다. App과 Blackmagic Cloud를 활용하면 더욱 간편하고, 신속한 촬영이 가능해지지만 기본 기능만으로도 훌륭한 성능을 보이고 있다.

2. PTZ Camera

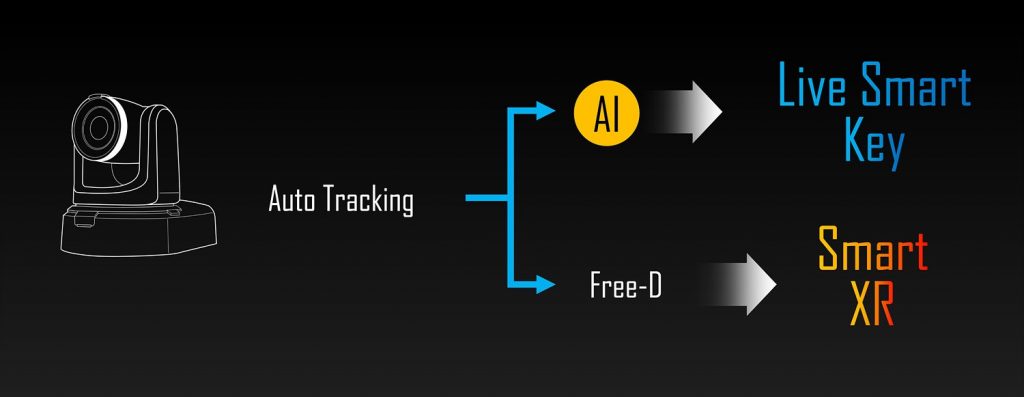

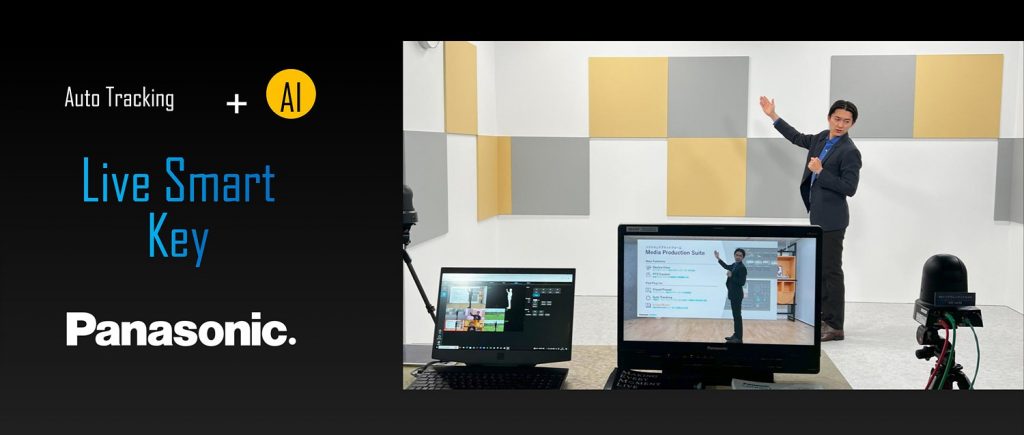

PTZ 카메라의 사용과 활용이 점차 늘어나면서 최신 기술이 적용된 PTZ 카메라가 등장하고 있다. 이미 화질에서는 기존 카메라와 대등할 정도의 성능을 자랑하고 있으며, 최근 Auto Tracking이 가능한 PTZ 카메라의 등장으로 촬영과 제작에 있어 새로운 변화가 생겨나고 있다. 이 Auto Tracking 기술에 AI가 적용되며, ‘Live Smart Key’라는 명칭으로 손쉽게 촬영 배경을 바꿀 수가 있게 된다. 일반환경에서 실시간 키 작업이 가능해져 굳이 크로마키 작업을 하지 않아도 실시간 AI 분석과 배경 합성을 통해 원하는 배경 효과를 만들어 낸다.

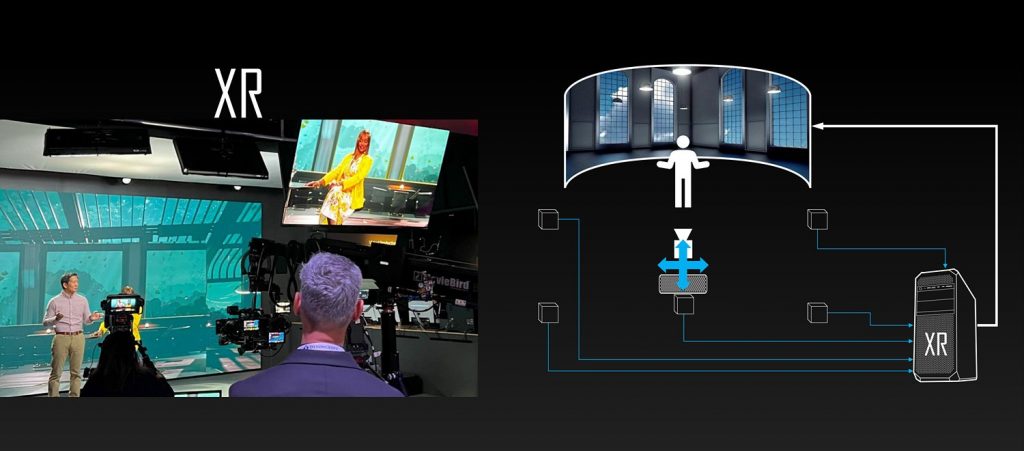

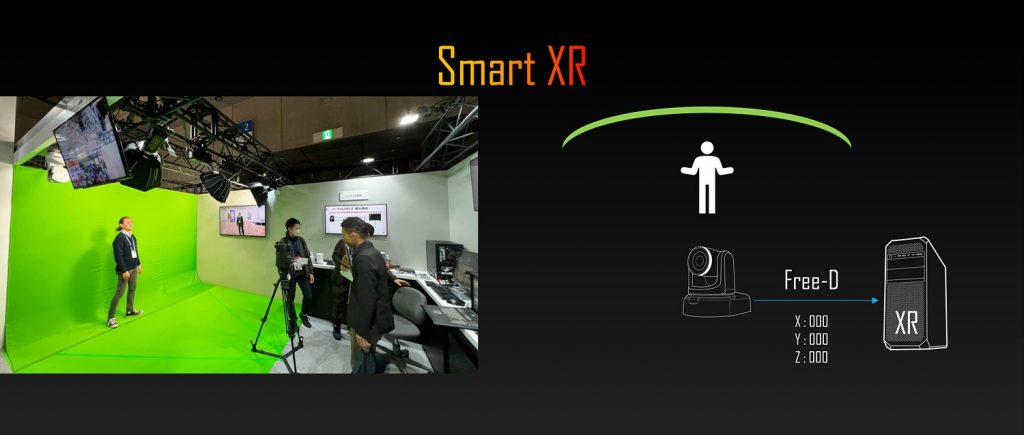

또한, Auto Tracking에 Free-D 프로토콜 기술이 더해지면 ‘Smart XR’이라고 해서 간단하게 XR 시스템 효과를 낼 수 있다. 전통적인 XR 촬영에서는 배경의 역할을 하는 전광판(LED Wall)과 중앙에 카메라, 그리고 위치 센서의 결과에 더해 XR 장치에서 실시간 배경이미지를 만들어 낸다. 값비싼 XR 지원 장비들과 공간이 필요하며, 결과적으로 비용이 많이 들 수밖에 없다. 하지만 Smart XR에서는 Auto Tracking을 지원하는 PTZ 카메라의 팬, 틸트, 줌으로 생겨나는 X, Y, Z 좌표값의 변화를 Free-D 프로토콜로 XR 장비에 전달하면 기존의 크로마키 배경에서도 XR 효과를 낼 수 있다. 장소와 비용의 문제에서 보다 효율성이 높아지는 방법으로 ‘라이브 XR의 경량화’라는 새로운 트렌드를 만들어 낼 수 있게 된다.

종합해보면, 기존 XR 시스템의 고성능, 고비용 특징을 저비용에서도 어느 정도 활용할 수 있게 되며, 지금까지 나왔던 Auto Tracking을 기반으로 AI와 Free-D 기술이 모두 적용된다면, 일반 배경에서도 사람을 추적하여 실시간으로 배경을 만들어 내는 것이 가능해지게 되는 것이다. 중소 규모의 스튜디오에서는 적은 비용으로 XR 촬영처럼 제작할 수 있어 기존의 가상 스튜디오를 대체할 수 있게 된다.

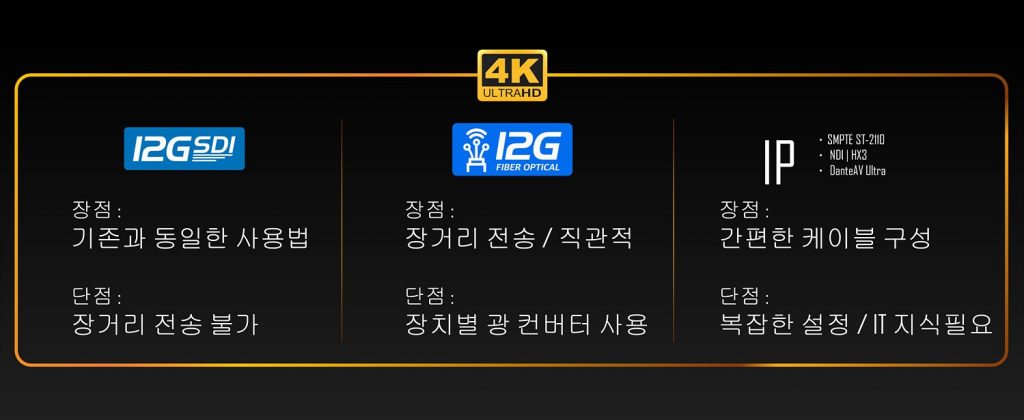

주요 이슈 2. 12G-Fiber Optical

다음으로 카메라 연결에 대해 살펴보면, 전통적인 SDI 방식이 무난하게 잘 쓰이고 있으나 넓은 대역폭이 있어야 하는 4K 콘텐츠의 등장으로 기존 SDI 방식을 개선한 12G-SDI와 IP를 이용한 연결이 보편화되고 있는 상황이다. 그런데 여기에 더해 12G-Fiber Optical 방식이 새롭게 등장했다. 기존 12G-SDI의 단점이 연결 거리의 제한이었지만 10km까지 연결가능해 이를 극복했으며, IP 방식과 같이 추가적인 지식을 필요로 하지 않는다. 기존 SDI 신호를 광으로 바꿔 보내주는 방식이기 때문이다. 때문에 장비 간 연결에 있어 광 컨버가 필요하며, 문제가 될 수 있는 딜레이는 발생하지 않는다. 무엇보다 직접 카메라와 장비를 연결할 수 있는 점과 연결 거리의 제한이 없어진다는 점이 매력적으로 다가온다.

최신 PTZ 카메라는 SFP+ 광 단자를 통해 12G-Fiber Optical을 지원하며, 이미 12G-Fiber Optical을 지원하는 다양한 장비가 출시되었고, 활발히 지원될 전망이다. 그리고 광 컨버터 연결 방식에서 LC와 ST 규격이 있는데 방송에서는 ST 방식이 추천되었다.

주요 이슈 3. Multi Viewer

멀티뷰어 시장에도 변화가 생기고 있다. 4K 제작으로 많은 소스를 보기가 현실상 쉽지 않게 되었다. 9개의 화면을 4K로 채운다면 12G×9 = 108Gbps 정도로 많은 대역폭을 필요로 한다. 그리고 로컬 카메라만이 아닌 인터넷/클라우드로 전달되는 소스들, 라이브 IP 장비까지 멀티뷰어를 통해 모니터링하는 요구가 높아지고 있다. 각 장비 연결에 디코더를 달아 베이스밴드로 바꿔주면 되지만, 현실적으로 쉽지 않은 부분이다. 이를 PTZ 카메라 연결에서는 손쉽게 해결할 수 있는데, 소스 대역폭을 줄여서 전송하는 것으로 PTZ 카메라에서 IP Low Bandwidth 출력을 지원한다면, 원본 소스는 스위처에 연결하고, 멀티뷰어에는 낮은 대역폭으로 연결한다. 1280×720의 화질로 3Mbps의 대역폭 정도만 차지하기 때문에 대역폭 관리가 대폭 줄어들게 된다. 이광희 대표는 “이렇게 발생하는 문제를 합리적으로 해결해나갈 수 있게 되는 것이 기술 발전의 묘미라고 볼 수 있다.”라고 전했다.

주요 이슈 4. Cloud

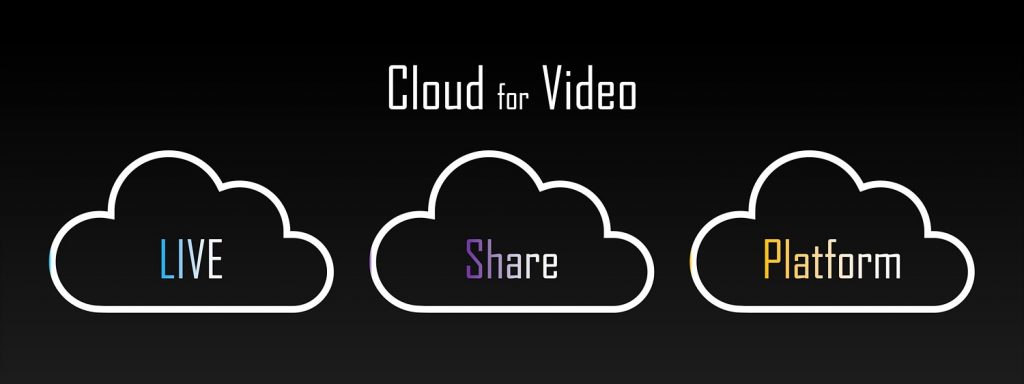

aws, Adobe Frame.io, Sony Ci Media, Blackmagic, BirdDog 등 시중에 다양한 클라우드 서비스가 제공되고 있다. 그러나 뜬구름 잡는 것처럼 클라우드 서비스는 너무 많은 의미를 내포하고 있어 클라우드 서비스 간 구분이 필요하다. 이광희 대표는 자체적으로 클라우드 서비스를 ‘LIVE’, ‘Share’, ‘Platform’ 클라우드로 구분할 수 있다고 설명했다.

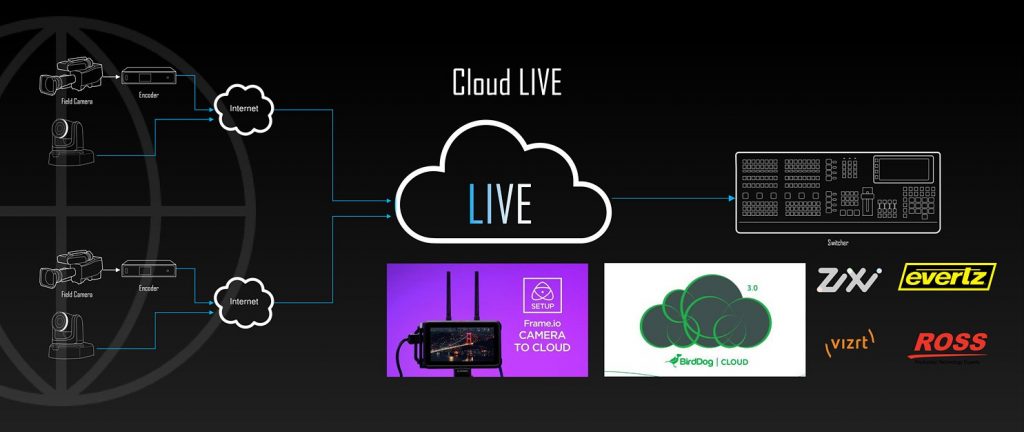

먼저, LIVE 클라우드는 원격지에서의 카메라 소스를 클라우드에 올리고, 반대편에서는 이를 다운 받아 제작하는 형식이다. 위성을 사용하여 중계하는 SNG(Satellite News Gathering)를 대체할 수 있을 것으로 전망되고 있다.

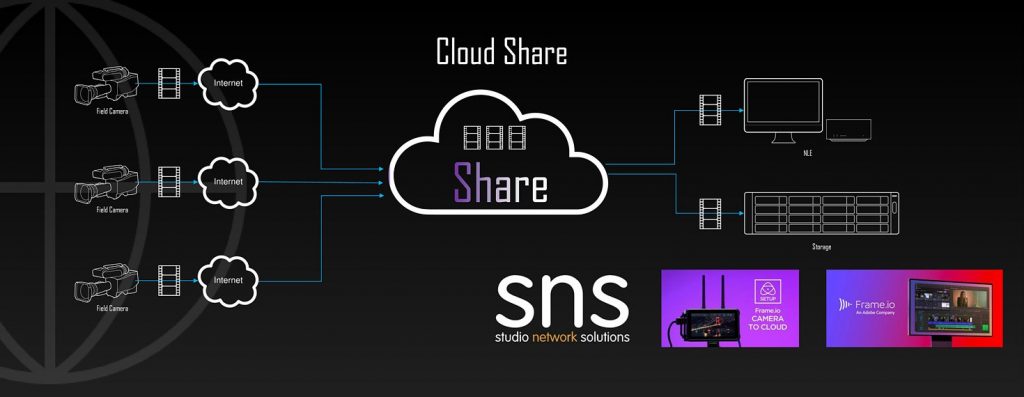

Share(공유) 클라우드는 구글 클라우드처럼 일종의 스토리지와 같이 사용될 수 있다. 설명에서는 sns(studio network solutions)의 공유 클라우드가 소개되었는데 ‘File to Cloud’로 실시간 편집이 가능하며, ‘Cloud to Cloud’와 같이 클라우드에서 클라우드로 백업하는 기능을 말한다. ‘Nomad Cloud’는 인터넷 여건이 안 좋은 환경에서 클라우드를 통한 Proxy 편집이 가능해지며, AI Storage 기능은 AI가 스토리지 안의 내용을 분석하여 태그를 걸어주어 한결 데이터 분류를 손쉽게 할 수 있어진다.

마지막으로 Platform 클라우드는 기존의 스위처, 레코더, NLE, 플레이어와 같은 하드웨어 장비를 클라우드로 대체하여 사용자에게는 라이센스를 제공하여 제작하는 방식이다. 제작에 필요한 하드웨어의 없이 라이브 비디오를 클라우드로 입력하고, 클라우드에서 제작하여 원격으로 비디오 스위칭을 할 수 있다. 하지만 인터넷이 끊어진다면 모든 제작 과정이 멈추게 될 수 있어 아직은 위험 부담이 있어 보인다.

주요 이슈 5. AI

올 한해 AI가 전 세계적으로 이슈였다. AI는 콘텐츠 제작의 다양한 영역에서 사용되고 있으며, 그 적용은 더욱 넓어질 것으로 예상되고 있는데 다섯 번째 이슈 설명에서는 Adobe의 AI 사례에 대해 소개되었다. NLE와 AI가 만나 텍스트 기반의 편집이 가능해지고 있다. 전에 선보인 베타 버전이 아닌 정식 버전으로 출시되었으며, 타임라인에서 텍스트를 통해 편집이 더욱 쉬워질 전망이다.

Adobe MAX 행사에서 전달되었다시피 adobe는 AI의 기능으로 ‘지능형 분석’과 ‘지능형 생성’에 기반하여 집중적으로 개발하고 있다. 몇 가지 사례가 설명되었는데 배경과 사람을 레이어로 구분하고, 배경을 실시간으로 생성해내는 기능이나 겹친 사람을 각 레이어로 나누어 가려진 부분을 생성해주는 기능이 소개되었다.

그리고 저화질의 동영상을 HD 화질로 업스케일링 해내며, 원본을 재창조하기 때문에 앞으로 4K, 8K의 화질로도 만들어 낼 수 있을 것으로 예상되었다. 동영상에서 선택 부분을 바로 수정하는 기능은 제작 시 와이어 제거와 같이 CG 장비를 이용한 반복되는 작업을 손쉽게 줄여줄 것으로 보였으며, 선택한 부분에 넥타이라고 치면, 동영상에서 인물의 그림자, 앵글을 적용하여 깔끔하게 넥타이를 만들어 주는 기능과 같이 AI를 이용해 Adobe Premiere 등에서 콘텐츠를 새롭게 분석하고, 생성해낼 수 있다.

AI를 활용한 다른 예시로는 그림을 간략히 그려내면 보다 완성된 형태로 만들어 주며, 채색도 해낼 뿐만 아니라 애니메이션화도 가능하다. 그림체를 인식하고 학습하여 시나리오만 있다면 AI를 통해 애니메이션을 만들어 낼 수도 있어 보인다.